如果說我看得比別人更遠(yuǎn)些,,那是因?yàn)槲艺驹诰奕说募绨蛏稀?/span>

——?牛頓

當(dāng)談?wù)撋疃葘W(xué)習(xí)變成一件很酷的事情時(shí),,作為其子領(lǐng)域的自然語言處理(英文簡稱“NLP”)也逐漸被世人熟知,站到了人工智能大舞臺的最前列,。

上一期,我們借著深度學(xué)習(xí)三巨頭獲頒圖靈獎的話題,,討論了深度學(xué)習(xí)技術(shù)的三大應(yīng)用領(lǐng)域,,特別是其中基于自然語言處理的金融科技應(yīng)用更是譽(yù)存科技的核心能力與業(yè)務(wù)之一。

打鐵還需自身硬,。今天我們不說應(yīng)用,,只論這門技術(shù)的幾個(gè)重點(diǎn)。文章基于譽(yù)存科技深度學(xué)習(xí)小組工作經(jīng)驗(yàn)所撰,,希望會對初入人工智能領(lǐng)域,,想要了解NLP的同學(xué)有所幫助。

01 關(guān)于NLP的基本常識

在這里,,筆者首先要向大家推薦一本NLP領(lǐng)域的經(jīng)典教材《Speech and Language Processing 》,,里面包含了 NLP 的基礎(chǔ)知識、語言學(xué)掃盲知識,、基本任務(wù)以及解決思路,。閱讀此書,你會接觸到很多 NLP 的最基本任務(wù)和知識,,比如 tagging, parsing,,coreference, semantic role labeling 等等,這對于全局地了解 NLP 領(lǐng)域有著極其重要的意義,。

為什么要推薦大家讀這本書呢,?因?yàn)椴环e跬步無以至千里。

以最近大熱BERT為例,,它是谷歌發(fā)布的開源自然語言處理模型,,在問答系統(tǒng)、自然語言推理和釋義檢測(paraphrase detection)等任務(wù)中均取得了突破性的進(jìn)展,。尤其是訓(xùn)練 ?language model (LM)的隨機(jī)替換更是刷新了各項(xiàng)NLP任務(wù)的成績,。那么,隨機(jī)替換是什么,?其本質(zhì)就是語言建模里面基于 interpolation 的平滑方式,,而基于 interpolation 的 LM 平滑,在本書中早有闡釋,。

02 為什么學(xué)NLP很重要,?

眾所周知,語言是人類智慧的偉大結(jié)晶,,也是人與人之間溝通交流的基本手段,而機(jī)器作為異次元生物不能直接與人對話,,需要特殊的傳感器和字節(jié)符號,,于是就產(chǎn)生了交流障礙。自然語言處理作為一種人工智能技術(shù),能幫助機(jī)器識別人類語言,,并分析,、理解、改變或生成它,,是打破人機(jī)交流屏障的重要技術(shù)手段,。

從目前的趨勢來看,人工智能是未來,,其發(fā)展勢不可擋,。不必說從事互聯(lián)網(wǎng)的人們已經(jīng)制造出的海量數(shù)據(jù)/信息,未來還將持續(xù),,這大千世界還存在其他海量結(jié)構(gòu)化,、半結(jié)構(gòu)化和非結(jié)構(gòu)化數(shù)據(jù)。就線上的結(jié)構(gòu)化數(shù)據(jù)而言,,在大數(shù)據(jù),、云計(jì)算技術(shù)的通力整合下,其技術(shù)已基本成熟和穩(wěn)定,,而對于半結(jié)構(gòu)化和非結(jié)構(gòu)化數(shù)據(jù)的處理,,因?yàn)樯婕暗膹?fù)雜性,在當(dāng)前和未來更多領(lǐng)域應(yīng)用都具有極大的困難和挑戰(zhàn),。

智能時(shí)代,,不僅企業(yè)需要懂 NLP 技術(shù)的人來處理這些海量非結(jié)構(gòu)化數(shù)據(jù),研發(fā)人員也需要利用NLP技術(shù)輕松實(shí)現(xiàn)人機(jī)交互,。從這點(diǎn)來看,,NLP的重要性已不言而喻,而各大招聘網(wǎng)站上列出的NLP算法專家薪酬更是一個(gè)簡單粗暴但在理的佐證,。

03 經(jīng)典NLP模型

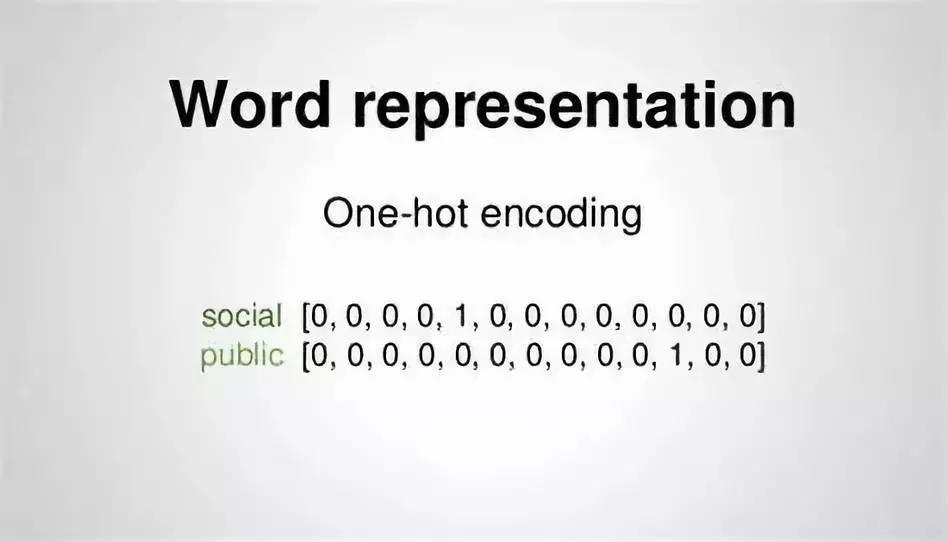

自然語言處理的第1步通常都是將輸入的文字轉(zhuǎn)成數(shù)字化,。

NLP中最直觀的文字表示方法是One-hot Representation. 這種方法把每個(gè)詞表示為一個(gè)以詞匯量為大小的向量。該向量中除了一個(gè)元素為1,,其他都為0.

這種表示方法很簡潔,,但不能編碼詞與詞之間的關(guān)系,因?yàn)槿魏蝺蓚€(gè)詞的詞向量的的相似度都為0. Word Embedding (詞嵌入) 可以將詞表示從 One-hot Representation轉(zhuǎn)成一個(gè)定長的,、連續(xù)的稠密向量,。之所以稱為稠密,因?yàn)橐粋€(gè)詞經(jīng)詞嵌入之后,,特征維度相對于原來的維度(也即是詞匯表的大?。┐鬄闇p小。詞嵌入是語言模型的“副產(chǎn)品”,。語言模型的基本思想是對出現(xiàn)在上下文環(huán)境里的詞進(jìn)行預(yù)測,。詞嵌入通過訓(xùn)練之后能夠體現(xiàn)出詞與詞之間的關(guān)系。語言模型的訓(xùn)練屬于非監(jiān)督學(xué)習(xí),故大規(guī)模訓(xùn)練語料(如wikipedia)很容易獲得,。

通過訓(xùn)練一個(gè)語言模型,,得到詞嵌入矩陣,再使用該矩陣作為輸入訓(xùn)練其他NLP模型,,這種思想在一定程度上對BERT模型的提出產(chǎn)生影響,。

04 我們的應(yīng)用

前面已提到過BERT模型在NLP任務(wù)中刷新了多項(xiàng)記錄。

譽(yù)存科技深度學(xué)習(xí)小組也結(jié)合NLP最新研發(fā)成果與公司的實(shí)際業(yè)務(wù)需求,,第一時(shí)間將BERT預(yù)訓(xùn)練模型運(yùn)用到了文本分類,、命名實(shí)體抽取、新聞情感分析,、文本摘要,、文本聚類和中英文翻譯等方面,并取得了很好的成果,。

下面簡單介紹下這幾個(gè)具體NLP任務(wù)的作用:

文本分類的目的是更加高效便捷找到用戶關(guān)心的文本類型,。

命名實(shí)體識別是抽取文本中人名、地名和機(jī)構(gòu)名,,有助于找到文本的主體以及主體的屬性,。

新聞情感分析是確定新聞內(nèi)容所描述的情感傾向;不同的傾向意味著主體(個(gè)人或者公司)在經(jīng)歷好的,、不好的或者中性的事件,。

文本摘要的目的是化繁為簡,將目標(biāo)文檔從一個(gè)長文本轉(zhuǎn)成一個(gè)短文本(通常在100字以內(nèi)),,并盡量保持核心思想不變,。

文本聚類是將講述相同話題的新聞或者其他文檔分門別類,有利于找出文檔中不同事件的受關(guān)注程度,。

中英文翻譯則是將這兩種語言的文檔翻譯成某一種語言,,方便文檔的閱讀和理解。

BERT模型的強(qiáng)大之處就在于,,它已經(jīng)從數(shù)百萬篇文章當(dāng)中學(xué)習(xí)到了字與字,、詞與詞之間的關(guān)系。這種能力為構(gòu)建在BERT預(yù)訓(xùn)練模型之上的具體事務(wù)模型(如文本分類)提供了語境信息,,使得事務(wù)模型在僅使用少量訓(xùn)練樣本的情況下就能表現(xiàn)就好的效果,。

最后,給大家一個(gè)小小的建議:多看關(guān)于NLP的論文,,特別是子領(lǐng)域相關(guān)的一些研究成果,,包括文本分類、實(shí)體識別,、情感分析等等,。另外,,基本的數(shù)學(xué)邏輯也需要搞懂,,畢竟天天都在用算法,,無時(shí)無刻不在優(yōu)化,數(shù)學(xué)太渣,,會浪費(fèi)很多時(shí)間的,。

PS:本文部分圖片來源于網(wǎng)絡(luò),如有侵權(quán)請聯(lián)系刪除,。